Hallo, in search.google.com

Wenn druckt der link zeigt,

search.google.com robots.txt legt,

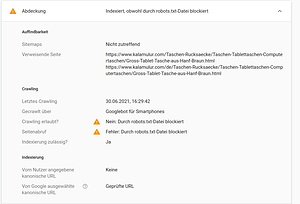

Wie das Bild zeigt, das probleme bekommt weil ich in meinen robots.txt , Disallow: /*?cur= habe…, um dieses probleme zu lösen, sollte ich *?cur=** erlaube ?

Hallo Joseba

alle URLs mit *?cur=x werden ausgeschlossen sein um Duplicate Content zu vermeiden Duplicate Content - SISTRIX

Der Hintergrund ist, dass der Seiteninhalt sich wahrscheinlich nur in der Währung unterscheiden wird und der restliche Inhalt gleich ist.

Viele Grüße,

Viel danke für deinen antwort!

jetzt ich weiß die bedeutung von cur=x , aber was kann ich mache um nicht weiter die warnung von search.google.com

Gerne.

Ich würde die robots.txt nicht ändern.

In den ehemaligen Webmaster Tools von Google (jetzt Google Search Console) gab es die Option bestimmte URL Parameter zu unterbinden beim Crawling dazu existieren auch noch Anleitungen z.B. Frühjahrsputz: URL-Parameter-Tool | Blog von Google Search Central | Google for Developers

joseba

July 5, 2021, 10:55am

5

Ich habe in support.google nach diesem probleme gesucht, einem person der Ähnliche probleme hat, haben gesagt zu machen, was du mir empfiehlt nicht machen…

nimm die Sperren in der robots.txt raus damit Google das noindex sehen kann.

Hast Du den bereits probiert die Seite aus dem Index löschen zu lassen?

Wenn Du die robots.txt änderst besteht die Gefahr, dass Dir weitere Seiten Seiten als Fehler angezeigt werden.

joseba

July 5, 2021, 12:18pm

7

Hast Du den bereits probiert die Seite aus dem Index löschen zu lassen?

nein, um das zu machen, soll ich in Stammdaten > Grundeinstellungen > SEO ?

Wenn Du die robots.txt änderst besteht die Gefahr, dass Dir weitere Seiten Seiten als Fehler angezeigt werden.

Als du über dieses Sachen auskennst, ich möchte die robots.txt nichts verändert…

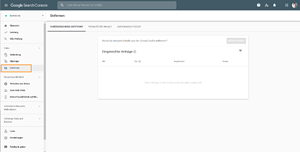

Du kannst einzelne Unterseiten über Google Search Console für Löschung aus Google Index beantragen unter https://search.google.com/search-console/removals

Dazu musst Du oben im Suchfeld die exate Unterseite mit ?cur=3 am Ende eingeben und dann einen Antrag auf Entfernung stellen.

Damit verbunden wäre die Hoffnung, dass Dir der Fehler zukünftig unter Google Search Console nicht mehr angezeigt wird.

1 Like

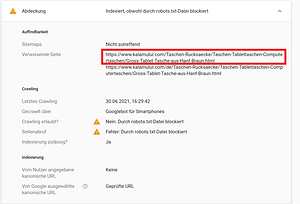

Danke, ich habe gemacht wie du sagst…ich kenne dieser button, ich benutze um alter seite zu lösen…, aber ich denke das probleme bekomme weil auf SEO etwas falsch geschrieben habe…

Das Bild zeigt wo ungefähr das probleme steht,

Dein Kern-Problem dann das Währungen Dropdown

Du könntest den Links für die weiteren Währungen mit dem Attribut no-follow belegen

<a class="dropdown-link" href="...?cur=3" title="USD" rel="nofollow">USD</a>

Weitere Infos unter Ausgehende Links für Google eingrenzen | Search Central und Was ist ein nofollow-Link? Alles was du wissen musst (ohne Fachjargon!)

joseba

July 5, 2021, 1:57pm

11

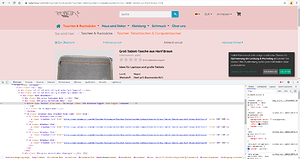

Danke, du meinst der Datei currencies.tpl in tpl/widget/header, in der Zeile 15, verändert,

von

<a class="dropdown-link" href="[{$_cur->link|oxaddparams:$oView->getDynUrlParams()}]" title="[{$_cur->name}]"><span>[{$_cur->name}]</span></a>

nach

<a class="dropdown-link" href="...?cur=3" title="USD" rel="nofollow">USD</a>

fast ein bisschen mitdenken

<a class="dropdown-link" href="[{$_cur->link|oxaddparams:$oView->getDynUrlParams()}]" title="[{$_cur->name}]" rel="nofollow"><span>[{$_cur->name}]</span></a>

1 Like

joseba

July 5, 2021, 2:18pm

13

so, die zeile 15 bleibt gleich, nur der Tag rel="nofollow" hinzufügen…

ja genau das Attribute rel="nofollow" hinzufügen

joseba

July 5, 2021, 2:35pm

15

Danke für deinen bemüht !

ich wünsche dir eine gute Wochen!

1 Like

system

July 5, 2022, 2:35pm

16

This topic was automatically closed 365 days after the last reply. New replies are no longer allowed.